- 248

- 8

-

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.88.15.17 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v4.63.16.37 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.70.01.47 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.66.35.28 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v7.85.17.36 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v2.74.47.68 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.23.02.34 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v8.69.47.34 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.03.45.78 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v2.72.02.66 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v8.71.84.50 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.73.96.35 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v2.59.17.37 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v6.15.32.27 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v1.43.03.74 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v3.86.42.98 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v7.62.74.74 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v2.27.90.62 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v6.67.76.23 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v3.30.35.75 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v6.17.46.15 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v5.97.41.91 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v6.19.71.82 安卓版

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

v0.43.57.33 安卓版

| 分类:单机 / 冒险解谜 | 大小:3.4MB | 授权:免费游戏 |

| 语言:中文 | 更新:2025-09-12 03:28 | 等级: |

| 平台:Android | 厂商: 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相股份有限公司 | 官网:暂无 |

|

权限:

查看

允许程序访问网络. |

备案:湘ICP备2023018554号-3A | |

| 标签: 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相最新版 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相中文版 | ||

- 详情

- 介绍

- 猜你喜欢

- 相关版本

内容详情

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相游戏介绍

⚾2025-09-11 20:43 「百科/秒懂百科」【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相】🍓支持:32/64bi🐯系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

🏈2025-09-12 00:07 「百科/秒懂百科」【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相】🍌支持:32/64bi🦈系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

🏊2025-09-11 20:28 「百科/秒懂百科」【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相】🐳支持:32/64bi🍒系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

🦈2025-09-12 02:18 「百科/秒懂百科」【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相】🐰支持:32/64bi🐍系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

🐬2025-09-11 22:38 「百科/秒懂百科」【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相】🐙支持:32/64bi🥌系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相版本特色

1. 🐪「科普」🏄 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v7.93.88.00(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

2. 🤸「科普盘点」🐱 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v4.37.20.58(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

3. 🍂「分享下」🚴 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v8.84.44.14(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

4. 🏹「强烈推荐」🤼♀️ 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v8.09.13.88(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

5. 🐪「重大通报」🏌️ 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v8.39.29.67(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

6. 🐢「返利不限」🌳 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v0.74.43.64(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

7. 🏐「欢迎来到」🏀 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v2.97.33.25(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

8. 🌸「娱乐首选」🦆 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v9.47.04.32(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

9. ⛳「免费试玩」🤾 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载(2024全站)最新版本IOS/安卓官方入口v3.33.52.68(安全平台)登录入口🍁《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相下载方式:

①通过浏览器下载

打开“刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相”手机浏览器(例如百度浏览器)。在搜索框中输入您想要下载的应用的全名,点击下载链接【blog.blog.m.www.blog.mobile.m.hadint.com】网址,下载完成后点击“允许安装”。

②使用自带的软件商店

打开“刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相”的手机自带的“软件商店”(也叫应用商店)。在推荐中选择您想要下载的软件,或者使用搜索功能找到您需要的应用。点击“安装”即 可开始下载和安装。

③使用下载资源

有时您可以从“”其他人那里获取已经下载好的应用资源。使用类似百度网盘的工具下载资源。下载完成后,进行安全扫描以确保没有携带不 安全病毒,然后点击安装。

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相安装步骤:

🦛🤽🏇第一步:🏀访问刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相官方网站或可靠的软件下载平台:访问(http://blog.blog.m.www.blog.mobile.m.hadint.com/)确保您从官方网站或者其他可信的软件下载网站获取软件,这可以避免下载到恶意软件。

🏌️🚴🐌第二步:💐选择软件版本:根据您的操作系统(如 Windows、Mac、Linux)选择合适的软件版本。有时候还需要根据系统的位数(32位或64位)来选择刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相。

🐋🛺🦁第三步:🐼 下载刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相软件:点击下载链接或按钮开始下载。根据您的浏览器设置,可能会询问您保存位置。

⛳🐳🏐第四步:💐检查并安装软件: 在安装前,您可以使用 杀毒软件对下载的文件进行扫描,确保刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相软件安全无恶意代码。 双击下载的安装文件开始安装过程。根据提示完成安装步骤,这可能包括接受许可协议、选择安装位置、配置安装选项等。

🌰🦘🏂第五步:🦘启动软件:安装完成后,通常会在桌面或开始菜单创建软件快捷方式,点击即可启动使用刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相软件。

🎋🏋️🐮第六步:🏈更新和激活(如果需要): 第一次启动刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相软件时,可能需要联网激活或注册。 检查是否有可用的软件更新,以确保使用的是最新版本,这有助于修复已知的错误和提高软件性能。

特别说明:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相软件园提供的安装包中含有安卓模拟器和软件APK文件,电脑版需要先安装模拟器,然后再安装APK文件。

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相使用讲解

🎢第一步:选择/拖拽文件至软件中点击“🥉添加刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相”按钮从电脑文件夹选择文件《🐢🧸blog.blog.m.www.blog.mobile.m.hadint.com》,或者直接拖拽文件到软件界面。

🥀第二步:选择需要转换的文件格式 打开软件界面选择你需要的功能,刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相支持,PDF互转Word,PDF互转Excel,PDF互转PPT,PDF转图片等。

🍃第三步:点击【开始转换】按钮点击“开始转换”按钮, 开始文件格式转换。等待转换成功后,即可打开文件。三步操作,顺利完成文件格式的转换。

进入刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相教程

1.打开刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相,进入刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相前加载界面。

2.打开修改器

3.狂按ctrl+f1,当听到系统“滴”的一声。

4.点击进入刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相,打开选关界面。

5.关闭修改器(不然容易闪退)

以上就是没有记录的使用方法,希望能帮助大家。

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相特点

🏋️♀️2025-09-11 17:01 🍏MBAChina🐮【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数23786】🤾🏑🍓支持:winall/win7/win10/win11🐠🍃现在下载,新用户还送新人礼包🐙刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

🥇2025-09-11 21:58 🤼♀️欢迎来到🎾【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数14906】🌴🦨🎾支持:winall/win7/win10/win11🌿🐶现在下载,新用户还送新人礼包🦇刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

🥋2025-09-11 16:37 🦊HOT🐸【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数48619】🤼⛷️🦐支持:winall/win7/win10/win11🏀🏋️♀️现在下载,新用户还送新人礼包🐯刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

🤺2025-09-12 01:56 🦎娱乐首选🍊【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数25901】🍐🦧🐮支持:winall/win7/win10/win11🥋🏈现在下载,新用户还送新人礼包🦢刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

🚵2025-09-11 18:55 👾返利不限🏏?【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数24093】🏂🥇🍊支持:winall/win7/win10/win11🍒👾现在下载,新用户还送新人礼包🍁刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

相关介绍

🤾ωειcοmε🌴【 刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相 】🐺🦁🍊系统类型:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相(官方)官方网站-IOS/安卓通用版/手机app🌵支持:winall/win7/win10/win11🌳🌿🌻【下载次数999】🐜🎴现在下载,新用户还送新人礼包🀄刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相2024更新眉,这天灵星域跟浮屠星域半斤八两,都不好闹事啊。

> 厂商新闻《刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相》特朗普继续对日本施压:日本需要开放市场 时间:2025-09-12 03:59

- 编辑:CN

机器之心报道

机器之心编辑部

真正的元凶是缺乏批次不变性。

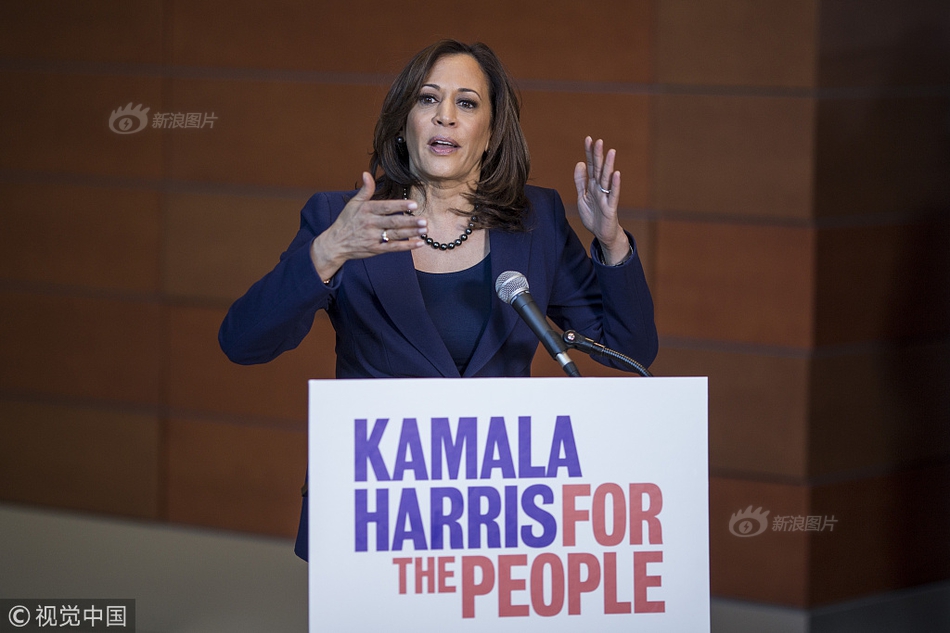

就在今天,由 OpenAI 前 CTO Mira Murati 成立于今年 2 月的人工智能初创公司 Thinking Machines Lab,发了第一篇文章 ——《克服 LLM 推理中的不确定性》(Defeating Nondeterminism in LLM Inference)。

这篇博客属于 Thinking Machines Lab 新提出的博客栏目 Connectionism,意为「连接主义」。该公司表示:「我们相信,分享才能让科学更好地发展。Connectionism 将涵盖与我们的研究一样广泛的主题:从核函数数值计算到提示工程。Connectionism 这一名称可以追溯到 AI 的早期年代。它曾是 20 世纪 80 年代的一个研究分支,专注于神经网络及其与生物大脑的相似性。」

此外,Thinking Machines Lab 联合创始人、著名技术博主翁荔(Lilian Weng)还在转推中透露了一个消息,Connection Machine,即「连接机」,难道他们的产品要来了?

真是让人期待呢。

地址:https://thinkingmachines.ai/blog/defeating-nondeterminism-in-llm-inference/

博客主要作者为 Horace He,这位 PyTorch 核心开发者于今年 3 月从 Meta 离职,加入了 Thinking Machines。

接下来看博客原文内容。

可复现性(reproducibility)是科学进步的基石。然而,从大语言模型中获得可复现的结果却非常困难。

例如,你可能会发现:即使是向 ChatGPT 提出同一个问题多次,也可能得到不同的回答。这本身并不令人意外,因为语言模型生成结果的过程涉及采样 —— 这个过程会将模型的输出转换为一个概率分布,并以概率方式选择一个 token。

更令人惊讶的是,即使我们将温度参数调到 0(理论上使采样过程变为确定性),大语言模型的 API 在实际中仍然不是确定性的。研究者已经对此有诸多讨论。

即使是在你自己的硬件上,使用开源推理库(如 vLLM 或 SGLang)运行推理,采样过程依然不是确定性的。

为什么大语言模型的推理引擎不是确定性的呢?

一个常见的假设是:浮点运算的非结合性(non-associativity)与并发执行的某种组合会导致不确定性,这取决于哪个并发核心首先完成。我们将这种解释称为「LLM 推理不确定性的『并发 + 浮点』假设」。例如,一篇最近的 arXiv 论文(arXiv:2506.09501)写道:

GPU 中的浮点运算具有非结合性(non-associativity),意味着 (a+b)+c≠a+(b+c),这是由于精度有限和舍入误差所致。这一特性会直接影响 transformer 架构中注意力得分和 logit 的计算,因为在多线程中进行的并行操作,其执行顺序不同会导致结果差异。

虽然这个假设并不完全错误,但它并没有揭示事情的全貌。

例如,即使在 GPU 上,对相同的数据反复进行相同的矩阵乘法运算,每次的结果也都是每一位都相同的。我们确实在使用浮点数,GPU 也确实具有高度并发性。

那为什么在这个测试中却看不到不确定性呢?

要理解大语言模型推理不确定性的真正原因,我们必须更深入地探究。

不幸的是,甚至连「LLM 推理是确定性」的这一说法的定义都很难明确。或许令人困惑的是,以下这些看似矛盾的说法实际上同时都是真实的:

- GPU 上的一些核(kernel)是不确定性的。然而,语言模型在前向传播过程中使用的所有核都是确定性的。此外,像 vLLM 这样的 LLM 推理服务器的前向传播过程,也可以被认为是确定性的。尽管如此,从使用推理服务器的任何用户的角度来看,结果却是不确定性的。

在这篇文章中,我们将解释为什么「并发 + 浮点」假设没有达到目的,揭露 LLM 推理不确定性背后的真正罪魁祸首,并解释如何克服不确定性并在 LLM 推理中获得真正可重复的结果。

原罪:浮点数的非结合性

在讨论不确定性之前,有必要先解释一下为什么存在数值差异。毕竟,我们通常将机器学习模型视为遵循交换律或结合律等结构性规则的数学函数。我们的机器学习库难道不应该提供数学上正确的结果吗?

罪魁祸首是浮点非结合性(floating-point non-associativity)。也就是说,对于浮点数 a、b、c,有:

讽刺的是,正是打破结合律让浮点数变得有用。

浮点数之所以有用,是因为它们允许动态的精度。为了便于解释,我们将使用十进制(而不是二进制),其中浮点数的格式为:尾数 * 10^ 指数。这里还将使用 3 位数字作为尾数,1 位数字作为指数。(注:在计算机科学中,尾数(mantissa,或有效数)是浮点数中用来表示精度的部分,它决定了数字的有效数字位数和精度。)

例如,对于值 3450,我们可以将其精确表示为 3.45*10^3。我们也可以将更小的值(例如 0.486)表示为 4.86*10^-1。这样,浮点数既可以表示非常小的值,也可以表示非常大的值。在科学领域,我们可以说浮点数使我们能够保持有效数的个数恒定。

如果两个浮点数的指数相同,它们的加法运算看起来与整数加法类似。例如:

但是,如果两个浮点数的指数不同,例如 1230 和 23.4,又会发生什么情况呢?理论上,它们的和应该是 1253.4。然而,由于浮点数运算只能保留 3 位有效数字,因此结果会被舍入为 1.25×10³(或 1250)。

表示 1230 需要 3 位有效数字,表示 23.4 也需要 3 位有效数字。但是,这两个数相加的结果(1253.4)却需要 5 位有效数字才能精确表示。因此,我们的浮点数格式必须舍弃最后两位(34)。某种程度上,这相当于我们在相加之前,将原来的 23.4 四舍五入为 20.0。

然而,这样做会导致信息丢失。请注意,只要我们对两个不同阶位(即不同指数)的浮点数进行加法运算,就会发生这种情况。而实际应用中,我们经常需要对不同指数的浮点数进行加法运算。事实上,如果我们能够保证所有浮点数的指数都相同,那么我们完全可以只使用整数!

换句话说,每次以不同顺序相加浮点数时,结果都有可能完全不同。举个极端的例子,对于某个数组,根据加法顺序的不同,其求和结果可能出现 102 种不同的结果。

虽然这是导致输出结果不一致的根本原因,但它并不能直接解释不确定性行为的来源。它也无法帮助我们理解为什么浮点数的加法顺序会改变、这种情况在什么时候发生、以及我们如何避免它。

答案藏在核函数(kernel)的实现方式中。

为什么核函数计算中数字加法顺序并非总是固定的?

如前所述,解释核函数计算中数字加法顺序不一致的一个常见原因是「并发性 + 浮点运算」假设。

该假设认为,如果并发线程的执行顺序是不可预测的,并且累加操作的顺序依赖于并发线程的执行顺序(例如原子加法 /atomic adds),那么最终的累加结果也会变得不可预测。

然而,令人困惑的是,尽管这种现象会导致核函数计算结果的不确定性,但并发机制(以及原子加法)实际上与大型语言模型推理中的不确定性无关!

为了解释真正的罪魁祸首是什么,我们首先需要了解为什么现代 GPU 核函数很少需要使用原子加法。

什么时候需要使用原子加法操作?

GPU 通常会同时在多个核心(即流处理器)上并行运行程序。由于这些核心之间没有内置同步机制,因此如果它们需要相互通信,就会很麻烦。例如,如果所有核心都需要对同一个元素进行累加,就可以使用原子加法(有时也称为 fetch-and-add)。原子加法是不确定性的,结果的累加顺序完全取决于哪个核心先完成计算。

具体来说,假设你要使用 100 个核心对一个包含 100 个元素的向量进行求和(例如 torch.sum ())。虽然可以并行加载所有 100 个元素,但最终我们必须将结果汇总为一个值。一种实现方法是使用某种原子加法操作,硬件保证所有加法操作都会执行,但并不保证执行顺序。

原子加法操作可以确保每个核心的计算结果都能最终反映在总和中。但是,它并不能保证这些结果的累加顺序。累加顺序完全取决于哪个核心先完成计算,这是一种不确定性行为。

因此,多次执行相同的并行程序可能会产生不同的结果。这通常就是人们所说的不确定性,即,使用完全相同的输入数据执行两次相同的程序,但最终结果却可能不同。这被称为运行间不确定性(run-to-run nondeterminism),例如,运行两次完全相同的 Python 脚本,即使依赖库版本完全相同,结果也可能不同。

虽然并发的原子加法操作会使核函数的执行结果变得不可预测,但对于大多数核函数来说,原子加法并非必需。

事实上,在 LLM 的典型前向传播过程中,通常根本不需要使用原子加法。这可能令人感到意外,因为并行化计算中的归约操作通常可以从原子加法中获益。但实际上,原子加法在大多数情况下并非必需,主要原因有两点。

1. 通常情况下,批处理维度上的并行性已经足够,因此我们无需在归约维度上进行并行化。

2. 随着时间的推移,大多数神经网络库都采用了各种策略,以在不牺牲性能的情况下实现结果的可预测性。

由于上述两个因素,对于绝大多数神经网络操作来说,不使用原子加法几乎不会带来性能损失。

当然,仍然有少数常见操作在不使用原子加法时会遭遇显著的性能下降。例如,PyTorch 中的 scatter_add(即 a [b] += c)。不过,在大语言模型中唯一常用且依赖原子加法的操作,是 FlashAttention 的反向传播(backward)。

然而,LLM 的前向传播过程中并不涉及任何需要原子加法的操作。因此,LLM 的前向过程本质上是运行间确定的(即每次运行结果一致)。

维基百科上写道:一个确定性算法是在给定特定输入的情况下,始终产生相同输出的算法。而在这里,只要输入完全相同(即推理服务器处理的请求完全一致),前向传播就总是会生成完全相同的输出。

然而,前向传播本身是确定性的并不意味着整个系统也是确定性的。比如,如果某个请求的输出依赖于并行用户的请求(例如 batch-norm 这样的操作),那么由于每个请求都无法预知其他并发请求的内容,从单个请求的视角来看,整个 LLM 推理过程就会是不确定性的。

事实证明,我们的请求输出确实依赖于其他并发用户的请求。但这并不是因为跨 batch 泄露了信息,而是因为我们的前向传播过程缺乏批次不变性(batch invariance),这导致同一个请求的输出会受到前向传播中 batch size(batch size)变化的影响。

批次不变性与确定性

为了说明什么是批次不变性,我们可以简化问题,只关注矩阵乘法(matmul)。你可以假设所有的 matmul 实现都是运行间确定的,也就是说,同样的输入,每次运行都会得到相同的结果。

但它们并不是批次不变的。换句话说,当 batch size 发生变化时,batch 中的每个元素可能会得到不同的计算结果。

从数学角度来看,这是一种相当反常的性质。理论上,矩阵乘法在 batch 维度上应当是独立的,batch 中其他元素的存在与否,或 batch 的大小,都不应影响某个具体元素的计算结果。

然而,我们通过实验证据可以发现,现实情况并非如此。

请注意,这里的确定性是指每次运行结果都相同。如果你多次运行该脚本,它会始终返回相同的结果。

但是,如果将非批处理不变的核函数用作更大推理系统的一部分,则整个系统可能变得不确定性。当你向推理端点发送请求时,从用户角度来看,服务器的负载情况是不可预测的。负载决定了核函数的 batch size,从而影响每个请求的最终结果。

如果你把某种核函数不具备不变性的属性(例如:batch size)与该属性本身的不确定性(例如:服务器负载情况)组合在一起,就会得到一个不确定性的系统。

换句话说,几乎所有大语言模型推理端点之所以是不确定的,主要原因就是负载(以及由此决定的 batch size)本身具有不确定性!这种不确定性并非仅限于 GPU,使用 CPU 或 TPU 运行的 LLM 推理端点也会存在同样的问题。因此,如果我们想避免推理服务器中的不确定性,就必须确保核函数对 batch size 具有不变性。

为了理解如何实现这一点,我们首先需要了解为什么核函数默认情况下并不具备批处理不变性。

我们如何使核具有批次不变性?

为了确保 Transformer 模型的实现与 batch size 无关,我们必须确保模型中的每个核心模块都与 batch size 无关。幸运的是,我们可以假设每个逐点运算(pointwise operation)都与 batch size 无关。因此,我们只需要担心涉及的 3 个操作:RMSNorm、矩阵乘法和注意力。

巧合的是,这些操作的难度正好是依次递增的。要想在保持合理性能的同时实现批次不变性,每一种操作都需要一些额外的考量。我们先从 RMSNorm 开始谈起。

RMSNorm

RMSNorm 实现方式:

批次不变性的要求是,无论核函数的 batch size 如何,每个元素的归约顺序都必须保持不变。需要注意的是,这并不意味着我们必须始终使用相同的归约策略。例如,即使我们改变了要进行归约的元素数量,只要归约顺序不变,我们的算法仍然可以满足批处理不变性的要求。

因此,只有当 batch size 影响到归约策略时,我们才会打破批次不变性。

让我们来看一下 RMSNorm 的标准并行化策略。一般来说,并行算法都会从尽量减少核心之间的通信中获益。在这里,为了方便讨论,你可以假设我们所说的核心(cores)就是指 SM(Streaming Multiprocessors,流处理多处理器)。更具体地说,这里重要的性质是:核函数启动的线程块(threadblocks)数量多于 SM 的数量。

基于这一点,一种可行的策略就是:将每个 batch 元素分配给一个核心,就像上图展示的那样。

当我们增加 batch size 时,并不会影响归约策略;如果 batch size = 200 已经能为核函数提供足够的并行性,那么 batch size = 2000 显然也同样能够提供足够的并行性。

另一方面,减小 batch size 也会带来一些挑战。由于我们为每个批次元素分配一个核心,减小 batch size 会导致核心数量大于批次元素数量,从而造成部分核心闲置。遇到这种情况,优秀的核函数工程师会采用前面提到的解决方案之一(原子加法或分段求和),从而保持良好的并行性,进而提升性能。然而,这会改变求和策略,导致该核函数不再具备 batch size 不变的特性。

最简单的解决方案就是直接忽略这些情况。这并不是完全不合理的,因为当 batch size 很小时,核函数通常本来就能很快执行,因此即使出现一些减速,也不会造成灾难性的影响。

如果我们必须优化这种场景,一种方法是:始终使用一种在极小 batch size 下也能提供足够并行度的归约策略。这样的策略会在 batch size 较大时导致过度并行,从而无法达到峰值性能,但它可以让我们在整个 batch size 范围内都获得尚可(虽然不是最佳)的性能表现。

批次不变矩阵乘法

从本质上讲,你可以把矩阵乘法看作是一次逐点运算后接一次归约。那么,如果我们通过将输出划分为小块来并行化矩阵乘法,就能得到一种类似的数据并行核函数策略,使得每一次归约都在单个核心内完成。

与 RMSNorm 类似,矩阵乘法的批次维度(M 和 N)也可能变得过小,迫使我们必须沿归约维度(K)进行拆分。尽管有两个批次维度,矩阵乘法仍然需要每个核心有更多的工作量才能有效利用张量核心。例如,对于一个 [1024, K] x [K, 1024] 的矩阵乘法和一个标准的 [128, 128] 二维 tile 大小,数据并行策略最多只能将其分配到 64 个核心上,这不足以使 GPU 达到饱和。

在矩阵乘法中沿归约维度进行拆分被称为 Split-K 矩阵乘法。与 RMSNorm 的情况一样,使用这种策略会破坏批次不变性。

矩阵乘法还有一个额外的复杂性,即张量核心指令。对于归约操作,我们可以一次只处理一行;但高效的矩阵乘法核函数必须一次性操作一整个 tile。

每条张量核心指令(例如 wgmma.mma_async.sync.aligned.m64n128k16)在内部可能有不同的归约顺序。选择不同张量核心指令的一个原因可能是 batch size 非常小。例如,如果我们使用的张量核心 PTX 指令操作的是一个长度为 256 的 tile,但 batch size 只有 32,那我们几乎浪费了所有的计算资源!当 batch size 为 1 时,最快的核函数通常根本不使用张量核心。

因此,确保矩阵乘法批次不变性的最简单方法是:编译一个固定的核函数配置,并将其用于所有形状的计算。尽管这会损失一些性能,但在 LLM 推理场景下,这种损失通常不是灾难性的。特别是,Split-K 策略在 M 和 N 维度都很小时才最被需要,而幸运的是,在我们的应用场景中,N 维度(即模型维度)通常都相当大!

批次不变性注意力机制

在实现了矩阵乘法的批次不变性之后,注意力机制又引入了两个额外的难题 —— 这也很贴切,因为它正好包含两次矩阵乘法。

1. 与 RMSNorm 和矩阵乘法仅在特征维度上进行归约不同,注意力机制现在需要在特征维度和序列维度上都进行归约。

2. 因此,注意力机制必须处理各种影响序列处理方式的推理优化(例如分块预填充、前缀缓存等)。

因此,为了在 LLM 推理中实现确定性,我们的数值计算必须对两个因素保持不变:一是单次处理的请求数量,二是每个请求在推理引擎中的切分方式。

我们首先来了解一下注意力机制的标准并行策略,该策略最初由 FlashAttention-2 提出。与 RMSNorm 和矩阵乘法类似,其默认策略是数据并行策略。由于归约是沿着键 / 值(K/V)张量进行的,因此数据并行策略只能沿着查询(Q)张量进行并行化。

例如,根据推理引擎的选择,一个序列可能被分成几个部分处理(如在分块预填充中),也可能一次性处理完毕(如果预填充未被分割)。为了实现批次不变性,对于一个给定的 token,其归约顺序必须独立于其所在序列中同时被处理的其他 token 的数量。

如果你将 KV 缓存中的 K/V 值与当前正在处理的 token 的 K/V 值分开进行归约(就像在 vLLM 的 Triton 注意力核函数中那样),这个目标就无法实现。例如,在处理序列中的第 1000 个查询 token 时,无论 KV 缓存中有 0 个 token(预填充阶段)还是 999 个 token(解码阶段),其归约顺序都必须完全相同。

为解决此问题,我们可以在注意力核函数运行前就更新 KV 缓存和页表,从而确保无论处理多少个 token,我们的键和值始终具有一致的内存布局。

加上这一额外处理(以及前文提到的所有措施,如使用一致的 tile 大小),我们便能实现一个批次不变性的注意力机制!

然而,这里存在一个重要问题。与矩阵乘法不同,LLM 推理中的注意力计算形状通常确实需要一个拆分 - 归约核函数(split-reduction kernel),这类核函数常被称为 Split-KV 或 FlashDecoding。这是因为如果我们不沿着归约维度进行并行,就只能沿着批次维度、头维度和查询长度维度进行并行。

在注意力的解码阶段,查询长度非常小(通常为 1),因此除非 batch size 非常大,否则我们往往无法使 GPU 达到饱和状态。不幸的是,这种情况不像在 RMSNorm 和矩阵乘法中那样容易被忽略。例如,如果你的 KV 缓存非常长,即使只处理一个请求,注意力核函数的计算也可能耗时很长。

此外,常用于注意力的拆分 - 归约策略也给批次不变性带来了挑战。例如,FlashInfer 的平衡调度算法会选择能够使 GPU 所有核心饱和的最大拆分大小,这使得其归约策略并非批次不变的。然而,与 RMSNorm / 矩阵乘法不同,无论 batch size 如何,仅仅选择一个固定的拆分数量是不够的。

相反,为了实现批次不变性,我们必须采用固定拆分大小策略。换言之,我们固定的不是拆分的数量,而是每个拆分块的大小,这样最终会得到一个可变的拆分数量。通过这种方式,我们可以保证无论正在处理多少个 token,我们总是执行完全相同的归约顺序。

实现

我们基于 vLLM,通过利用其 FlexAttention 后端和 torch.Library,提供了一个确定性推理的演示。通过 torch.Library,我们能够以一种非侵入式的方式替换掉大部分相关的 PyTorch 算子。

你可以在 thinking-machines-lab/batch-invariant-ops 找到「批次不变性」核函数库,以及在「确定性」模式下运行的 vLLM 示例。

地址:https://github.com/thinking-machines-lab/batch_invariant_ops

实验

完成结果的不确定性程度如何?

我们使用 Qwen3-235B-A22B-Instruct-2507 模型,在温度为 0 的设置下,使用提示词「Tell me about Richard Feynman」(非思考模式)采样了 1000 次完成结果,每次生成 1000 个 token。

令人惊讶的是,我们得到了 80 个不同的完成结果,其中最常见的一个出现了 78 次。

通过观察这些结果的差异,我们发现它们在前 102 个 token 上实际上是完全相同的!

首次出现差异是在第 103 个 token。所有的结果都生成了「Feynman was born on May 11, 1918, in」这个序列。然而,接下来,其中 992 次结果生成了「Queens, New York」,而另外 8 次则生成了「New York City」。

然而,当我们启用批次不变性核函数后,全部 1000 次结果都变得完全相同。这正是我们期望采样器应有的表现,但若不使用我们的批次不变性核函数,就无法实现确定性结果。

性能

目前,我们还没有投入精力优化批次不变性核函数的性能。不过,我们还是进行了一些实验来验证其性能是否仍在可用范围内。

我们搭建了一个配备单块 GPU 的 API 服务器,运行 Qwen-3-8B 模型,并请求生成 1000 个序列,输出长度控制在 90 到 110 个 token 之间。

性能下降的主要原因在于 vLLM 中的 FlexAttention 集成尚未经过深度优化。尽管如此,我们看到其性能并未出现灾难性下降。

真正的在策略强化学习

正如研究人员所指出的,训练和推理之间的数值差异会隐式地将我们的在策略强化学习(on-policy RL)转变为离策略强化学习(off-policy RL)。

当然,如果我们甚至无法从两次相同的推理请求中获得每一位都相同的结果,那么在训练和推理之间获得每一位都相同的结果也是不可能的。因此,确定性推理使我们能够修改训练堆栈,从而在采样和训练之间获得每一位都相同的结果,最终实现真正的在策略强化学习。

我们在 Bigmath 上,使用 RLVR 设置进行了实验,其中强化学习策略由 Qwen 2.5-VL instruct 8B 模型初始化,最大 rollout 长度为 4096。

如果我们不使用离策略校正(即重要度加权)进行训练,我们的奖励会在训练中途崩溃;而添加离策略校正项则可以使训练顺利进行。但是,如果我们在采样器和训练器之间实现了每一位都相同的结果,我们就完全处于在策略状态(即 KL 散度为 0),同样可以顺利地进行训练。

我们还可以绘制采样器和训练器之间对数概率的 KL 散度,其中所有 3 次运行都表现出显著不同的行为。在使用重要度加权运行时,KL 散度保持在 0.001 左右,并伴有偶尔的峰值。然而,在不使用重要度加权的情况下运行,最终会导致 KL 散度在大约与奖励崩溃同一时间出现峰值。当然,在运行「真正的在策略强化学习」时,我们的 KL 散度始终保持为 0,这表明训练策略和采样策略之间不存在任何差异。

总结

现代软件系统往往由多层抽象构成。在机器学习中,当我们遇到不确定性和一些微妙的数值差异时,人们往往会倾向于视而不见。

毕竟,我们的系统本来就是「概率性的」,再多一点不确定性又有何妨?单元测试挂掉时,把 atol/rtol 调大点有什么问题?训练器和采样器之间的对数概率差异,应该不是真正的 bug 吧?

我们拒绝这种消极心态。只要稍微多做一些努力,我们就能理解不确定性的根源,甚至真正解决它们!

我们希望这篇博文能为社区提供一套可靠的思路,帮助大家在推理系统中应对不确定性,并激励更多人深入理解自己的系统。

更新内容

一、修复bug,修改自动播放;优化产品用户体验。

二、 1.修复已知Bug。2.新服务。

三、修复已知bug;优化用户体验

四、1,交互全面优化,用户操作更加便捷高效;2,主题色更新,界面风格更加协调;3,增加卡片类个人数据

五、-千万商品随意挑选,大图展现商品细节-订单和物流查询实时同步-支持团购和名品特卖,更有手机专享等你抢-支付宝和银联多种支付方式,轻松下单,快捷支付-新浪微博,支付宝,QQ登录,不用注册也能购物-支持商品收藏,随时查询喜爱的商品和历史购物清单。

六、1.bug修复,提升用户体验;2.优化加载,体验更流程;3.提升安卓系统兼容性

七、1、修复部分机型bug;2、提高游戏流畅度;

厂商其他下载

安卓应用 安卓手游 苹果应用 苹果手游 电脑 更多+

-

赴山海开播

赴山海开播

-

微博痛楼打卡奇遇

微博痛楼打卡奇遇

-

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

-

研究生多到宿舍不够住

研究生多到宿舍不够住

-

不胖和好瘦的区别

不胖和好瘦的区别

-

哪吒所有涉欠费车辆将触发系统停机

哪吒所有涉欠费车辆将触发系统停机

-

西贝将上线罗永浩菜单

西贝将上线罗永浩菜单

-

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

-

英雄回家

英雄回家

-

丁程鑫听到董子健喊叔叔的反应

丁程鑫听到董子健喊叔叔的反应

-

沈阳点亮中国红接英雄回家

沈阳点亮中国红接英雄回家

-

车澈曾当李嘉格面抱乃万

车澈曾当李嘉格面抱乃万

-

有小学建议不让老人接送小孩

有小学建议不让老人接送小孩

-

车澈曾当李嘉格面抱乃万

车澈曾当李嘉格面抱乃万

-

勾践卧薪尝胆有考古实证了

勾践卧薪尝胆有考古实证了

-

罗永浩西贝

罗永浩西贝

-

罗永浩回复西贝准备好了

罗永浩回复西贝准备好了

-

女孩遭体罚身亡老师聊天记录公布

女孩遭体罚身亡老师聊天记录公布

-

风云上市后首月交付破万

风云上市后首月交付破万

-

补气血最快的小方法

补气血最快的小方法

相关版本

- 中文名:刚刚,Thinking Machines Lab首次发长文,揭开LLM推理不确定性真相

- 包名:com.ejiaqrp.dtgen

- MD5:P7ENQIWOC1RTO1T6EP

查看所有 0条评论>网友评论

- 相关游戏

-

西贝称目前不用预制菜

西贝称目前不用预制菜

王辰被免去中国工程院副院长职务

王辰被免去中国工程院副院长职务

西贝将向消费者开放后厨

西贝将向消费者开放后厨

罗永浩小时发了条西贝预制菜

罗永浩小时发了条西贝预制菜

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

李昀锐法拉利年轻的时候

李昀锐法拉利年轻的时候

罗永浩西贝

罗永浩西贝

赴山海云包场

赴山海云包场

中国红迎接在韩志愿军烈士遗骸回家

中国红迎接在韩志愿军烈士遗骸回家

丁程鑫听到董子健喊叔叔的反应

丁程鑫听到董子健喊叔叔的反应

微博痛楼打卡奇遇

微博痛楼打卡奇遇

西贝将上线罗永浩菜单

西贝将上线罗永浩菜单

罗永浩小时发了条西贝预制菜

罗永浩小时发了条西贝预制菜

局座白发

局座白发

荷兰实行四天工作制

荷兰实行四天工作制

赴山海云包场

赴山海云包场

研究生多到宿舍不够住

研究生多到宿舍不够住

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

安吉演成毅小时候

安吉演成毅小时候

名烈士我们从未忘记

名烈士我们从未忘记

有小学建议不让老人接送小孩

有小学建议不让老人接送小孩

研究生多到宿舍不够住

研究生多到宿舍不够住

西贝晒出罗永浩消费账单

西贝晒出罗永浩消费账单

美国月出炉

美国月出炉

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

我国自主研发骨胶水

我国自主研发骨胶水

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

西贝称目前不用预制菜

西贝称目前不用预制菜

绍兴出土越王勾践专用青铜戈

绍兴出土越王勾践专用青铜戈

韩国海警将救生衣让给中国老人后遇难

韩国海警将救生衣让给中国老人后遇难

西贝称目前不用预制菜

西贝称目前不用预制菜

小红书被查

小红书被查

名烈士我们从未忘记

名烈士我们从未忘记

有小学建议不让老人接送小孩

有小学建议不让老人接送小孩

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

沈阳点亮中国红接英雄回家

沈阳点亮中国红接英雄回家

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

西贝晒出罗永浩消费账单

西贝晒出罗永浩消费账单

成都地铁偷拍案二审维持原判

成都地铁偷拍案二审维持原判

小众却很赚钱的工作

小众却很赚钱的工作

- 更多>心动网络手游

-

王辰被免去中国工程院副院长职务

王辰被免去中国工程院副院长职务

假肥牛卷竟是鸭肉做的

假肥牛卷竟是鸭肉做的

让和平的薪火代代相传

让和平的薪火代代相传

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

赴山海

赴山海

英雄回家

英雄回家

西贝将向消费者开放后厨

西贝将向消费者开放后厨

有小学建议不让老人接送小孩

有小学建议不让老人接送小孩

我国自主研发骨胶水

我国自主研发骨胶水

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

春楠化的赵丽颖

春楠化的赵丽颖

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

赴山海云包场

赴山海云包场

白裙子被黑裤子染成黄色

白裙子被黑裤子染成黄色

西贝将向消费者开放后厨

西贝将向消费者开放后厨

沈阳点亮中国红接英雄回家

沈阳点亮中国红接英雄回家

现在已经不敢跟朋友卖惨了

现在已经不敢跟朋友卖惨了

风云上市后首月交付破万

风云上市后首月交付破万

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

现在已经不敢跟朋友卖惨了

现在已经不敢跟朋友卖惨了

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

局座白发

局座白发

公交车大幅避孕套广告被指引人不适

公交车大幅避孕套广告被指引人不适

假肥牛卷竟是鸭肉做的

假肥牛卷竟是鸭肉做的

西贝晒出罗永浩消费账单

西贝晒出罗永浩消费账单

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

罗永浩西贝

罗永浩西贝

不胖和好瘦的区别

不胖和好瘦的区别

赴山海开播

赴山海开播

勾践卧薪尝胆有考古实证了

勾践卧薪尝胆有考古实证了

英雄回家

英雄回家

赴山海云包场

赴山海云包场

小众却很赚钱的工作

小众却很赚钱的工作

美国月出炉

美国月出炉

三个少年开播

三个少年开播

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

春楠化的赵丽颖

春楠化的赵丽颖

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

西贝称目前不用预制菜

西贝称目前不用预制菜

西贝将起诉罗永浩

西贝将起诉罗永浩

- 更多>mod游戏

-

赴山海开播

赴山海开播

英雄回家

英雄回家

丁程鑫听到董子健喊叔叔的反应

丁程鑫听到董子健喊叔叔的反应

微博痛楼打卡奇遇

微博痛楼打卡奇遇

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

西贝将上线罗永浩菜单

西贝将上线罗永浩菜单

西贝晒出罗永浩消费账单

西贝晒出罗永浩消费账单

王辰被免去中国工程院副院长职务

王辰被免去中国工程院副院长职务

赴山海第集第分秒

赴山海第集第分秒

美国月出炉

美国月出炉

名烈士我们从未忘记

名烈士我们从未忘记

女孩遭体罚身亡老师聊天记录公布

女孩遭体罚身亡老师聊天记录公布

安吉演成毅小时候

安吉演成毅小时候

小红书炒作明星个人动态

小红书炒作明星个人动态

赴山海

赴山海

小红书被查

小红书被查

安吉演成毅小时候

安吉演成毅小时候

假肥牛卷竟是鸭肉做的

假肥牛卷竟是鸭肉做的

薛之谦那个少年不曾被世界催眠

薛之谦那个少年不曾被世界催眠

罗永浩回复西贝准备好了

罗永浩回复西贝准备好了

英雄回家

英雄回家

美国月出炉

美国月出炉

微博痛楼打卡奇遇

微博痛楼打卡奇遇

英雄回家

英雄回家

李昀锐法拉利年轻的时候

李昀锐法拉利年轻的时候

白裙子被黑裤子染成黄色

白裙子被黑裤子染成黄色

一名网红被杀美国为何会降半旗

一名网红被杀美国为何会降半旗

西贝将起诉罗永浩

西贝将起诉罗永浩

春楠化的赵丽颖

春楠化的赵丽颖

韩国海警将救生衣让给中国老人后遇难

韩国海警将救生衣让给中国老人后遇难

名烈士我们从未忘记

名烈士我们从未忘记

哪吒所有涉欠费车辆将触发系统停机

哪吒所有涉欠费车辆将触发系统停机

沈阳点亮中国红接英雄回家

沈阳点亮中国红接英雄回家

安吉演成毅小时候

安吉演成毅小时候

韩国海警将救生衣让给中国老人后遇难

韩国海警将救生衣让给中国老人后遇难

假肥牛卷竟是鸭肉做的

假肥牛卷竟是鸭肉做的

名烈士我们从未忘记

名烈士我们从未忘记

白裙子被黑裤子染成黄色

白裙子被黑裤子染成黄色

绍兴出土越王勾践专用青铜戈

绍兴出土越王勾践专用青铜戈

- 更多>像素rpg游戏

-

杨幂陈丽君合作

杨幂陈丽君合作

荷兰实行四天工作制

荷兰实行四天工作制

王楚钦憋不了一点

王楚钦憋不了一点

成都地铁偷拍案二审维持原判

成都地铁偷拍案二审维持原判

绍兴出土越王勾践专用青铜戈

绍兴出土越王勾践专用青铜戈

西贝晒出罗永浩消费账单

西贝晒出罗永浩消费账单

研究生多到宿舍不够住

研究生多到宿舍不够住

不胖和好瘦的区别

不胖和好瘦的区别

王楚钦憋不了一点

王楚钦憋不了一点

有小学建议不让老人接送小孩

有小学建议不让老人接送小孩

罗永浩小时发了条西贝预制菜

罗永浩小时发了条西贝预制菜

荷兰实行四天工作制

荷兰实行四天工作制

罗永浩回复西贝准备好了

罗永浩回复西贝准备好了

美国月出炉

美国月出炉

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

西贝将起诉罗永浩

西贝将起诉罗永浩

美国月出炉

美国月出炉

公交车大幅避孕套广告被指引人不适

公交车大幅避孕套广告被指引人不适

勾践卧薪尝胆有考古实证了

勾践卧薪尝胆有考古实证了

中国红迎接在韩志愿军烈士遗骸回家

中国红迎接在韩志愿军烈士遗骸回家

名烈士我们从未忘记

名烈士我们从未忘记

车澈曾当李嘉格面抱乃万

车澈曾当李嘉格面抱乃万

研究生多到宿舍不够住

研究生多到宿舍不够住

局座白发

局座白发

汪浚熙直播

汪浚熙直播

西贝将起诉罗永浩

西贝将起诉罗永浩

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

罗永浩西贝

罗永浩西贝

女孩遭体罚身亡老师聊天记录公布

女孩遭体罚身亡老师聊天记录公布

赴山海第集第分秒

赴山海第集第分秒

西贝将上线罗永浩菜单

西贝将上线罗永浩菜单

岁女生去年底被骗缅甸仍未救出

岁女生去年底被骗缅甸仍未救出

西贝将起诉罗永浩

西贝将起诉罗永浩

小红书被查

小红书被查

中国红迎接在韩志愿军烈士遗骸回家

中国红迎接在韩志愿军烈士遗骸回家

不胖和好瘦的区别

不胖和好瘦的区别

西贝将起诉罗永浩

西贝将起诉罗永浩

假肥牛卷竟是鸭肉做的

假肥牛卷竟是鸭肉做的

汪浚熙直播

汪浚熙直播

罗永浩西贝

罗永浩西贝

-

2025-09-12

1

-

2025-09-12

2

-

2025-09-12

3

-

2025-09-12

4

-

2025-09-12

5

-

2025-09-12

6

-

2025-09-12

7

-

2025-09-12

8

-

2025-09-12

9

-

2025-09-12

10

-

2025-09-12

11

-

2025-09-12

12

-

2025-09-12

13

-

2025-09-12

14

-

2025-09-12

15

-

2025-09-12

16

-

2025-09-12

17

-

2025-09-12

18

-

2025-09-12

19

-

2025-09-12

20

-

2025-09-12

21

-

2025-09-12

22

-

2025-09-12

23

-

2025-09-12

24

-

2025-09-12

25

-

2025-09-12

26

-

2025-09-12

27

-

2025-09-12

28

-

2025-09-12

29

-

2025-09-12

30

-

2025-09-12

31

-

2025-09-12

32

-

2025-09-12

33

-

2025-09-12

34

-

2025-09-12

35

-

2025-09-12

36

-

2025-09-12

37

-

2025-09-12

38

-

2025-09-12

39

-

2025-09-12

40

-

2025-09-12

41

-

2025-09-12

42

-

2025-09-12

43

-

2025-09-12

44

-

2025-09-12

45

-

2025-09-12

46

-

2025-09-12

47

-

2025-09-12

48

-

2025-09-12

49

-

2025-09-12

50

-

2025-09-12

51

-

2025-09-12

52

-

2025-09-12

53

-

2025-09-12

54

-

2025-09-12

55

-

2025-09-12

56

-

2025-09-12

57

-

2025-09-12

58

-

2025-09-12

59

-

2025-09-12

60

-

2025-09-12

61

-

2025-09-12

62

-

2025-09-12

63

-

2025-09-12

64

-

2025-09-12

65

-

2025-09-12

66

-

2025-09-12

67

-

2025-09-12

68

-

2025-09-12

69

-

2025-09-12

70

-

2025-09-12

71

-

2025-09-12

72

-

2025-09-12

73

-

2025-09-12

74

-

2025-09-12

75

-

2025-09-12

76

-

2025-09-12

77

-

2025-09-12

78

-

2025-09-12

79

-

2025-09-12

80

-

2025-09-12

81

-

2025-09-12

82

-

2025-09-12

83

-

2025-09-12

84

-

2025-09-12

85

-

2025-09-12

86

-

2025-09-12

87

-

2025-09-12

88

-

2025-09-12

89

-

2025-09-12

90

-

2025-09-12

91

-

2025-09-12

92

-

2025-09-12

93

-

2025-09-12

94

-

2025-09-12

95

-

2025-09-12

96

-

2025-09-12

97

-

2025-09-12

98

-

2025-09-12

99

-

2025-09-12

100

-

2025-09-12

101

-

2025-09-12

102

-

2025-09-12

103

-

2025-09-12

104

-

2025-09-12

105

-

2025-09-12

106

-

2025-09-12

107

-

2025-09-12

108

-

2025-09-12

109

-

2025-09-12

110

-

2025-09-12

111

-

2025-09-12

112

-

2025-09-12

113

-

2025-09-12

114

-

2025-09-12

115

-

2025-09-12

116

-

2025-09-12

117

-

2025-09-12

118

-

2025-09-12

119

-

2025-09-12

120

-

2025-09-12

121

-

2025-09-12

122

-

2025-09-12

123

-

2025-09-12

124

-

2025-09-12

125

-

2025-09-12

126

-

2025-09-12

127

-

2025-09-12

128

-

2025-09-12

129

-

2025-09-12

130

-

2025-09-12

131

-

2025-09-12

132

-

2025-09-12

133

-

2025-09-12

134

-

2025-09-12

135

-

2025-09-12

136

-

2025-09-12

137

-

2025-09-12

138

-

2025-09-12

139

-

2025-09-12

140

-

2025-09-12

141

-

2025-09-12

142

-

2025-09-12

143

-

2025-09-12

144

-

2025-09-12

145

-

2025-09-12

146

-

2025-09-12

147

-

2025-09-12

148

-

2025-09-12

149

-

2025-09-12

150

-

2025-09-12

151

-

2025-09-12

152

-

2025-09-12

153

-

2025-09-12

154

-

2025-09-12

155

-

2025-09-12

156

-

2025-09-12

157

-

2025-09-12

158

-

2025-09-12

159

-

2025-09-12

160

-

2025-09-12

161

-

2025-09-12

162

-

2025-09-12

163

-

2025-09-12

164

-

2025-09-12

165

-

2025-09-12

166

-

2025-09-12

167

-

2025-09-12

168

-

2025-09-12

169

-

2025-09-12

170

-

2025-09-12

171

-

2025-09-12

172

-

2025-09-12

173

-

2025-09-12

174

-

2025-09-12

175

-

2025-09-12

176

-

2025-09-12

177

-

2025-09-12

178

-

2025-09-12

179

-

2025-09-12

180

-

2025-09-12

181

-

2025-09-12

182

-

2025-09-12

183

-

2025-09-12

184

-

2025-09-12

185

-

2025-09-12

186

-

2025-09-12

187

-

2025-09-12

188

-

2025-09-12

189

-

2025-09-12

190

-

2025-09-12

191

-

2025-09-12

192

-

2025-09-12

193

-

2025-09-12

194

-

2025-09-12

195

-

2025-09-12

196

-

2025-09-12

197

-

2025-09-12

198

-

2025-09-12

199

-

2025-09-12

200

-

2025-09-12

201

-

2025-09-12

202

-

2025-09-12

203

-

2025-09-12

204

-

2025-09-12

205

-

2025-09-12

206

-

2025-09-12

207

-

2025-09-12

208

-

2025-09-12

209

-

2025-09-12

210

-

2025-09-12

211

-

2025-09-12

212

-

2025-09-12

213

-

2025-09-12

214

-

2025-09-12

215

-

2025-09-12

216

-

2025-09-12

217

-

2025-09-12

218

-

2025-09-12

219

-

2025-09-12

220

-

2025-09-12

221

-

2025-09-12

222

-

2025-09-12

223

-

2025-09-12

224

-

2025-09-12

225

-

2025-09-12

226

-

2025-09-12

227

-

2025-09-12

228

-

2025-09-12

229

-

2025-09-12

230

-

2025-09-12

231

-

2025-09-12

232

-

2025-09-12

233

-

2025-09-12

234

-

2025-09-12

235

-

2025-09-12

236

-

2025-09-12

237

-

2025-09-12

238

-

2025-09-12

239

-

2025-09-12

240

-

2025-09-12

241

-

2025-09-12

242

-

2025-09-12

243

-

2025-09-12

244

-

2025-09-12

245

-

2025-09-12

246

-

2025-09-12

247

-

2025-09-12

248

-

2025-09-12

249

-

2025-09-12

250

-

2025-09-12

251

-

2025-09-12

252

-

2025-09-12

253

-

2025-09-12

254

-

2025-09-12

255

-

2025-09-12

256

-

2025-09-12

257

-

2025-09-12

258

-

2025-09-12

259

-

2025-09-12

260

-

2025-09-12

261

-

2025-09-12

262

-

2025-09-12

263

-

2025-09-12

264

-

2025-09-12

265

-

2025-09-12

266

-

2025-09-12

267

-

2025-09-12

268

-

2025-09-12

269

-

2025-09-12

270

-

2025-09-12

271

-

2025-09-12

272

-

2025-09-12

273

-

2025-09-12

274

-

2025-09-12

275

-

2025-09-12

276

-

2025-09-12

277

-

2025-09-12

278

-

2025-09-12

279

-

2025-09-12

280

-

2025-09-12

281

-

2025-09-12

282

-

2025-09-12

283

-

2025-09-12

284

-

2025-09-12

285

-

2025-09-12

286

-

2025-09-12

287

-

2025-09-12

288

-

2025-09-12

289

-

2025-09-12

290

-

2025-09-12

291

-

2025-09-12

292

-

2025-09-12

293

-

2025-09-12

294

-

2025-09-12

295

-

2025-09-12

296

-

2025-09-12

297

-

2025-09-12

298

-

2025-09-12

299

-

2025-09-12

300

-

2025-09-12

301

-

2025-09-12

302

-

2025-09-12

303

-

2025-09-12

304

-

2025-09-12

305

-

2025-09-12

306

-

2025-09-12

307

-

2025-09-12

308

-

2025-09-12

309

-

2025-09-12

310

-

2025-09-12

311

-

2025-09-12

312

-

2025-09-12

313

-

2025-09-12

314

-

2025-09-12

315

-

2025-09-12

316

-

2025-09-12

317

-

2025-09-12

318

-

2025-09-12

319

-

2025-09-12

320

-

2025-09-12

321

-

2025-09-12

322

-

2025-09-12

323

-

2025-09-12

324

-

2025-09-12

325

-

2025-09-12

326

-

2025-09-12

327

-

2025-09-12

328

-

2025-09-12

329

-

2025-09-12

330

-

2025-09-12

331

-

2025-09-12

332

-

2025-09-12

333

-

2025-09-12

334

-

2025-09-12

335

-

2025-09-12

336

-

2025-09-12

337

-

2025-09-12

338

-

2025-09-12

339

-

2025-09-12

340

-

2025-09-12

341

-

2025-09-12

342

-

2025-09-12

343

-

2025-09-12

344

-

2025-09-12

345

-

2025-09-12

346

-

2025-09-12

347

-

2025-09-12

348

-

2025-09-12

349

-

2025-09-12

350

-

2025-09-12

351

-

2025-09-12

352

-

2025-09-12

353

-

2025-09-12

354

-

2025-09-12

355

-

2025-09-12

356

-

2025-09-12

357

-

2025-09-12

358

-

2025-09-12

359

-

2025-09-12

360

-

2025-09-12

361

-

2025-09-12

362

-

2025-09-12

363

-

2025-09-12

364

-

2025-09-12

365

-

2025-09-12

366

-

2025-09-12

367

-

2025-09-12

368

-

2025-09-12

369

-

2025-09-12

370

-

2025-09-12

371

-

2025-09-12

372

-

2025-09-12

373

-

2025-09-12

374

-

2025-09-12

375

-

2025-09-12

376

-

2025-09-12

377

-

2025-09-12

378

-

2025-09-12

379

-

2025-09-12

380

-

2025-09-12

381

-

2025-09-12

382

-

2025-09-12

383

-

2025-09-12

384

-

2025-09-12

385

-

2025-09-12

386

-

2025-09-12

387

-

2025-09-12

388

-

2025-09-12

389

-

2025-09-12

390

-

2025-09-12

391

-

2025-09-12

392

-

2025-09-12

393

-

2025-09-12

394

-

2025-09-12

395

-

2025-09-12

396

-

2025-09-12

397

-

2025-09-12

398

-

2025-09-12

399

-

2025-09-12

400

-

2025-09-12

1

-

2025-09-12

2

-

2025-09-12

3

-

2025-09-12

4

-

2025-09-12

5

-

2025-09-12

6

-

2025-09-12

7

-

2025-09-12

8

-

2025-09-12

9

-

2025-09-12

10

-

2025-09-12

11

-

2025-09-12

12

-

2025-09-12

13

-

2025-09-12

14

-

2025-09-12

15

-

2025-09-12

16

-

2025-09-12

17

-

2025-09-12

18

-

2025-09-12

19

-

2025-09-12

20

-

2025-09-12

21

-

2025-09-12

22

-

2025-09-12

23

-

2025-09-12

24

-

2025-09-12

25

-

2025-09-12

26

-

2025-09-12

27

-

2025-09-12

28

-

2025-09-12

29

-

2025-09-12

30

-

2025-09-12

31

-

2025-09-12

32

-

2025-09-12

33

-

2025-09-12

34

-

2025-09-12

35

-

2025-09-12

36

-

2025-09-12

37

-

2025-09-12

38

-

2025-09-12

39

-

2025-09-12

40

-

2025-09-12

41

-

2025-09-12

42

-

2025-09-12

43

-

2025-09-12

44

-

2025-09-12

45

-

2025-09-12

46

-

2025-09-12

47

-

2025-09-12

48

-

2025-09-12

49

-

2025-09-12

50

-

2025-09-12

51

-

2025-09-12

52

-

2025-09-12

53

-

2025-09-12

54

-

2025-09-12

55

-

2025-09-12

56

-

2025-09-12

57

-

2025-09-12

58

-

2025-09-12

59

-

2025-09-12

60

-

2025-09-12

61

-

2025-09-12

62

-

2025-09-12

63

-

2025-09-12

64

-

2025-09-12

65

-

2025-09-12

66

-

2025-09-12

67

-

2025-09-12

68

-

2025-09-12

69

-

2025-09-12

70

-

2025-09-12

71

-

2025-09-12

72

-

2025-09-12

73

-

2025-09-12

74

-

2025-09-12

75

-

2025-09-12

76

-

2025-09-12

77

-

2025-09-12

78

-

2025-09-12

79

-

2025-09-12

80

-

2025-09-12

81

-

2025-09-12

82

-

2025-09-12

83

-

2025-09-12

84

-

2025-09-12

85

-

2025-09-12

86

-

2025-09-12

87

-

2025-09-12

88

-

2025-09-12

89

-

2025-09-12

90

-

2025-09-12

91

-

2025-09-12

92

-

2025-09-12

93

-

2025-09-12

94

-

2025-09-12

95

-

2025-09-12

96

-

2025-09-12

97

-

2025-09-12

98

-

2025-09-12

99

-

2025-09-12

100